Zuletzt aktualisiert am: 10. Dezember 2025

Softwarequalität messen ist für moderne Organisationen heute essenziell: In der zunehmend digitalen und vernetzten Geschäftswelt von heute sind Softwaresysteme zu mission-critical Assets geworden, die Reliability, Scalability und langfristigen Business Value liefern müssen. Organisationen, die in komplexen Domänen wie Finance, Public Services, Logistics oder Enterprise Operations tätig sind, stehen zusätzlich vor der Herausforderung, große, business-critical Applications über viele Jahre hinweg zu betreiben und weiterzuentwickeln. Das Sicherstellen konsistenter Qualität in diesen Systemen erfordert ausgereifte, datengetriebene Quality Assurance (QA) – Praktiken, die fundierte Entscheidungen und ein effektives Risk Management ermöglichen.

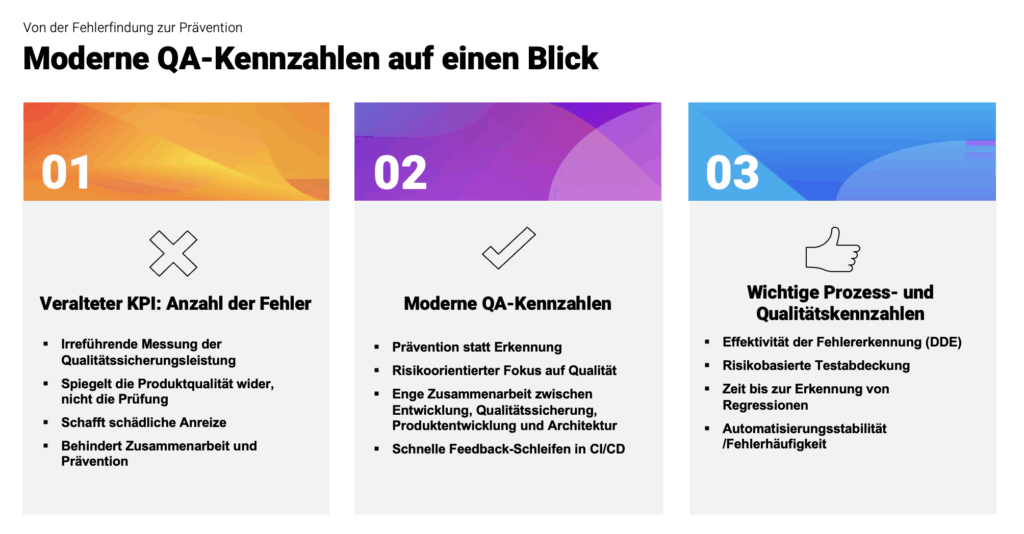

Trotz Fortschritten bei den Engineering-Praktiken und Quality-Frameworks verlassen sich viele Organisationen jedoch weiterhin auf veraltete Metriken, um ihre QA-Strategie zu steuern. Eines der häufigsten – und problematischsten – Beispiele ist die Nutzung der Anzahl gefundener „Defects” während des Testings als primärer Indikator für die Qualität oder die Leistung des Teams. Diese Kennzahl erscheint auf den ersten Blick zwar plausibel, vermittelt jedoch nur eine sehr eingeschränkte und oft irreführende Sicht auf den tatsächlichen Produktzustand, die Effektivität der Prozesse und die organisatorische Reife.

Dieser Artikel untersucht, wie man Softwarequalität messen kann und warum die Anzahl gefundener Fehler ein ungeeigneter KPI für komplexe Software-Ökosysteme ist und welche Risiken mit ihrer weiteren Verwendung verbunden sind. Zudem werden moderne, wertorientierte Metriken vorgestellt, die die tatsächliche Produktqualität besser widerspiegeln, kontinuierliche Verbesserungen unterstützen und sich an den strategischen Zielen von Organisationen ausrichten, die Qualität maximieren und gleichzeitig Kosten und Aufwand im Blick behalten möchten. Durch die Einführung eines ganzheitlicheren Messansatzes können Unternehmen die Zusammenarbeit stärken, das operative Risiko reduzieren und ihre Teams befähigen, Software zu entwickeln, die einen nachhaltigen geschäftlichen Einfluss hat.

Softwarequalität messen: Warum Fehlerzählungen irreführend sind

Die Anzahl gefundener Fehler wird in vielen Organisationen als Qualitäts- oder Effizienzkennzahl genutzt. Für komplexe Geschäftsanwendungen ist diese Metrik jedoch weder aussagekräftig noch steuerungsrelevant. Sie misst nicht die Leistung des Testteams, sondern vor allem die Qualität vorgelagerter Tätigkeiten wie Anforderungsanalyse, Architektur und Entwicklung. Hohe Fehlerzahlen entsprechen daher häufig einem Prozessproblem, nicht einer hohen Testeffizienz; niedrige Fehlerzahlen können hingegen Ergebnis reifer Prozesse sein, werden durch die KPI jedoch negativ interpretiert.

Darüber hinaus erzeugt die Kennzahl Fehlanreize: Sie fokussiert Teams auf die Quantität der Meldungen statt auf die Identifikation geschäftskritischer Risiken. Sie differenziert weder nach Schwere noch nach Impact und bietet keine Aussage über Testabdeckung oder Risikoreduzierung. Die KPI ist zudem stark abhängig von Faktoren, die außerhalb der QA liegen, wie Releaseumfang, Codequalität oder Komplexität der Änderungen. Aussagen über Effizienz oder Prozessreife sind damit verzerrt und nicht belastbar.

Aussagekräftige QA-Metriken, um Softwarequalität zu messen

Moderne Qualitätsstandards wie ISTQB und ISO/IEC 25010 unterstreichen, dass Softwarequalität multidimensional ist und nicht durch eine einfache Fehlerzählung abgebildet werden kann. Fachliche Studien zeigen darüber hinaus, dass Fehleranzahl weder zuverlässig mit Produktqualität noch mit Prozessgüte korreliert. Die KPI birgt zudem organisatorische Risiken, wie Zielkonflikte zwischen Entwicklung und Qualitätssicherung, die konstruktive Zusammenarbeit beeinträchtigen.

Wenn die Anzahl gefundener Fehlerzustände nicht die Leistung des Testteams widerspiegelt, wird deutlich, wie schwierig es ist, Softwarequalität zu messen und es stellt sich die Frage, welche Kennzahlen stattdessen sinnvoll sind. Wirksame Qualitätsmetriken müssen darauf abzielen, wie gut Teams Risiken verhindern, wie schnell sie diese erkennen und wie zuverlässig das Produkt im realen Einsatz funktioniert.

Solche Kennzahlen lassen sich grob in zwei Kategorien einteilen:

- Prozess- und qualitätsbezogene Metriken sowie

- Ergebnisorientierte, outcome-basierte Metriken.

Prozess- und qualitätsbezogene Metriken messen, wie stark die Qualitätssicherungsprozesse ausgeprägt sind und wie gut Teams zusammenarbeiten. Eine der wichtigsten Kennzahlen ist die Defect Detection Effectiveness (DDE), die das Verhältnis der vor dem Release gefundenen Fehlerzustände zu denen misst, die erst in Produktion auftreten. Eine hohe DDE steht für wirksame Teststrategien und eine gesunde Entwicklungs- und Delivery-Pipeline, während eine niedrige DDE auf Lücken hinweist, durch die Fehlerzustände in die Produktion gelangen. Ebenso wichtig ist die risikobasierte Testabdeckung, die sicherstellt, dass Testaktivitäten auf kritische, komplexe und risikoreiche Komponenten fokussiert werden, statt alle Bereiche gleichmäßig zu behandeln. Dadurch werden Ressourcen effizient dort eingesetzt, wo sie den größten Mehrwert liefern.

Die Zeit bis zur Erkennung von Regressionen dient als Indikator für die Effektivität der Automatisierung und die Reife der CI/CD-Pipeline. Je schneller Regressionen erkannt werden, desto geringer sind Aufwand und Kosten ihrer Behebung. Die Stabilität der Testautomatisierung, beispielsweise messbar über die Flakiness-Rate, zeigt, wie zuverlässig automatisierte Tests arbeiten. Instabile Tests untergraben Vertrauen, erzeugen Rauschen, verlangsamen Pipelines und binden unnötig Kapazität. Ebenfalls bedeutend sind die Klarheit der Anforderungen und die Geschwindigkeit der Feedbackschleifen. Klare Anforderungen verbessern das Testdesign, ermöglichen eine präzise Risikoerkennung und reduzieren Nacharbeit. Schnelle Feedbackschleifen sorgen für zeitnahe Klärungen, vermeiden Blockaden und fördern eine effiziente Zusammenarbeit zwischen allen Rollen. Zusammen geben diese Metriken einen präzisen Einblick in die Prozessreife, die Effektivität der Teamzusammenarbeit und den Umfang der frühzeitigen Fehlerprävention.

Ergebnisorientierte, outcome-basierte Metriken ergänzen dieses Bild, indem sie die tatsächliche Produktqualität aus Sicht der Nutzer messen. Die Produktionsfehlerdichte zeigt, wie viele Fehler nach dem Release im täglichen Einsatz auftreten und wie stark sie die Nutzererfahrung beeinflussen. Die Mean Time to Detect (MTTD) und die Mean Time to Confirm (MTTC) geben Aufschluss darüber, wie schnell die Organisation neue Fehlerzustände erkennt und bewertet. Eine kurze MTTD zeigt, dass Monitoring, Tests und Feedbackschleifen effektiv funktionieren, während eine kurze MTTC die Effizienz des Testteams bei der Reproduktion und Validierung von Fehlern demonstriert. Die Leackage-Rate kritischer Fehlerzustände schließlich zeigt, wie viele schwerwiegende Fehler trotz aller Maßnahmen in die Produktion gelangen. Eine niedrige Rate bedeutet, dass Risiken und Qualitätsprobleme früh erkannt und kontrolliert werden.

Gemeinsam ermöglichen diese prozess- und outcome-basierten Metriken ein umfassendes Bild der Softwarequalität und zeigen, wie Unternehmen Softwarequalität messen können: Sie stärken die Produktzuverlässigkeit, erhöhen die Releasegeschwindigkeit, senken operative Risiken und unterstützen ein skalierbares Engineering. Gleichzeitig fördern sie eine Kultur der gemeinsamen Verantwortung für Qualität, da sie systemische Zusammenhänge sichtbar machen und Verbesserungen im gesamten Produktentwicklungsprozess ermöglichen, ohne einzelne Personen isoliert zu bewerten.

Über Fehlerzahlen hinaus: Sinnvolle Qualitätsmessung

Moderne Qualitätssicherung ist daher präventiv, wertschöpfend und qualitätssichernd statt rückwärtsgewandte Fehlerzählung. Während Fehlerzahlen nur rückblickend bereits aufgetretene Probleme anzeigen, bieten Prozess-, Qualitäts- und Ergebniskennzahlen frühzeitige, proaktive und kontrollierbare Indikatoren, die echte Verbesserungen ermöglichen. Eine effektive Qualitätssicherung gestaltet den Lieferprozess, sichert Anforderungen über alle Qualitätsdimensionen hinweg, minimiert Risiken, erhöht die Effizienz und stellt sicher, dass die Software nachhaltig wartbar bleibt und einen echten Mehrwert bietet.

Erfahren Sie, wie Q12 Prävention, Zusammenarbeit und datengetriebene Qualität in den Mittelpunkt der Softwarebereitstellung stellt. Besuchen Sie unsere Q12-Webseiten.

FAQ: Sinnvolle QA-Metriken statt Fehlerzählung

Warum ist die Anzahl gefundener Defekte keine geeignete QA-Kennzahl?

Weil Fehler-Zahlen hauptsächlich die Qualität des gelieferten Codes widerspiegeln – nicht die Effizienz der QA. Sie werden stark von Faktoren beeinflusst, die außerhalb des QA-Einflusses liegen (z. B. Codequalität, Anforderungsklarheit, technische Schulden).

Welche Probleme entstehen durch Fehlerzählungen als KPI?

Fehler zählen erzeugt schädliche Anreize, führt zu Ticket-Inflation, lenkt den Fokus weg von wirklichen Risiken und behindert die Zusammenarbeit zwischen QA und Entwicklung. Es misst Masse statt Wirkung.

Warum finden starke QA-Teams häufig weniger Fehler?

Reife Teams arbeiten nach Shift-Left-Prinzipien, sind früh im Prozess eingebunden und verhindern Fehler, bevor sie entstehen. Eine niedrige Fehler-Zahl kann daher ein Zeichen hoher Produktqualität sein.

Welche QA-Metriken sind aussagekräftig?

Wichtige Prozess- und Qualitätsmetriken sind z. B.

– Defect Detection Effectiveness (DDE)

– Risikobasierte Testabdeckung

– Time to Detect Regressions

– Anforderungsklarheit & frühe Feedbackschleifen

– Stabilität der Testautomatisierung (Flakiness)

– Welche ergebnisbasierten Metriken sind relevant?

Unter anderem:

– Fehlerdichte in der Produktion

– Mean Time to Detect (MTTD)

– Mean Time to Confirm (MTTC)

– Rate kritischer Defektlecks

Wie sollten Metriken im Unternehmen genutzt werden?

Nicht zur Bewertung oder zum Vergleich von Teams, sondern zur kontinuierlichen Verbesserung: zur Identifikation von Trends, Engpässen und Risiken sowie zur Optimierung von Prozessen und Zusammenarbeit.

Was ist das zentrale Fazit des Artikels?

Die Fehlerzählung ist ein irreführender KPI. Die moderne Qualitätssicherung misst Prävention, Risikomanagement, Prozessreife und Produktzuverlässigkeit misst.